开始使用Procore Analytics 2.0

目录

- Procore Analytics云连接器

- 开始设置

- 选择数据连接方法

- 连接到 Power BI Desktop

- 使用 Android 连接到SQL Server (SSIS)

- 使用 Android 库连接到SQL Server

- 使用 Android Spark 连接到SQL Server

- 使用 Azure Functions 连接到 ADLS

- 使用 Android 连接到 ADLS

- 使用 Spark 连接到 ADLS

- 使用数据工

- 使用 Fability 笔记本连接到 Fabrik Lagehous

- 使用 Azure Functions 连接到SQL Server

- 使用数据工厂连接到SQL Server

- 使用 Fabur 笔记本连接到SQL Server

- 连接到数据块

- 使用 Android 连接到 Snowplace

- 使用 Android 连接到Amazon S3

- 建立你自己的联系

Procore Analytics云连接器

简介

Cloud Connector 是 Procore 与我们的客户共享数据、智能和分析的方式。这可以直接共享到 Power BI 或Tableau等报告工具。它也可以共享给客户的数据仓库、商店、Lee 或其他应用程序。客户甚至可以使用 Cloud Connector 构建对其数据的程序化访问,实现真正的自动化。Cloud Connector 基于 增量共享开放共享协议。

Procore Analytics 2.0 引导数据连接器选项

增量共享是业界第一个用于安全数据共享的开放协议,能够轻松与其他组织共享数据,无论他们使用哪种计算平台。许多应用程序可以使用 增量共享访问数据。但是,为了进一步提升客户体验,Procore 为以下平台添加了连接器、预构建代码和指南,以减少设置时间和复杂性以实现无缝、开箱即用的连接。

- SQL Server

- SSIS 脚本文件

- 巨龙库

- 巨龙星火

- Azure

- ADLS Azure Functions

- ADLS 巨龙

- ADLS 星火

- Lakhous 结构数据工厂

- Lakhous 布料笔记本

- SQL Server Azure Functions

- SQL Server结构数据工厂

- SQL Server结构笔记本

- 数据块

- 雪花

- Amazon S3

- 自行编写指南(GitHub)

即将推出更多数据连接器!

访问文档和代码

Procore Analytics产品中的综合文档和代码示例可直接在 Procore Web 应用程序中获得,可供 Procore 管理员访问。这些资源提供了分步说明、代码片段和最佳实践,以帮助你有效地设置和管理数据集成。

后续步骤

继续本指南的下一部分,开始设置过程。

如有其他查询或帮助,请联系你的客户经理或我们的支持团队。

验证权限

注意

- 必须在公司级别为公司的 Procore 账户启用Procore Analytics工具。

- 任何对Procore Analytics工具具有“管理员”级别访问权限的人都可以授予其他用户访问Procore Analytics工具的权限。

- 用户必须对Procore Analytics工具具有"管理员"级别的访问权限才能生成访问令牌。

- 用户在Procore Analytics目录中权限的任何变更最多需要 24 小时才能生效。

你必须确保分配适当的权限以生成访问令牌,以便开始将 Procore 数据连接到 BI 解决方案。 对Procore Analytics的访问权限链接到你的 Procore 登录凭证,从而允许生成单个访问令牌。访问令牌是你将在 BI 系统中输入以访问数据的一串数字。

通常,需要访问令牌的用户是数据工程师或 Power BI 开发人员。 如果你可以访问多家公司的Procore Analytics ,你的令牌将允许你从所有这些公司中提取数据。 令牌与你相关联,与你无关,与特定公司无关,因此它在你有权访问的所有公司中都保持不变。

默认情况下,公司和项目管理员将被授予管理员角色。 Procore Analytics工具允许以下用户访问级别:

- 无:无权限访问Procore Analytics数据。

- 管理员:对所有工具和项目的数据具有完全访问权限(某些标记为私密的数据除外,例如通信数据)。

有两种方法可以为单个用户分配权限:

撤销访问权限

当用户对 Procore Analytics 工具的权限被删除时,对Procore Analytics工具中数据的访问权限将被撤销。此外,如果用户的联系人记录变为非活动状态,他们也将无法访问Procore Analytics数据。

生成数据访问凭证

要开始访问 Procore 数据,有两种选项可生成数据访问凭证:databricks 直接连接方法或 Detail Share 令牌方法。访问令牌是你将在适用的数据连接器中输入的用于访问数据的一串数字。

注意事项

- 你必须启用Procore Analytics工具。

- 默认情况下,所有公司管理员都对目录中的 Analytics 具有"管理员"级别的访问权限。

- 任何对 Analytics 具有"管理员"级别访问权限的人都可以授予其他用户访问 Analytics 工具的权限。

- 用户必须具有分析工具的"管理员"级别访问权限才能生成数据令牌。

步骤

- 登录 Procore。

- 点击导航栏右上角区域的"账户和个人资料"图标。

- 点击我的个人资料设置。

- 在选择与Procore Analytics 的连接下,你有两个选项来生成凭证:

- Databricks 直接连接或使用 增量共享生成个人访问令牌。

- 输入为 Databricks 直接连接方法的Databricks 共享标识符,然后点击连接。请参阅将 Procore 数据连接到 Databricks 工作区以了解更多信息。

- 对于令牌方法,请选择增量共享令牌。

- 请务必选择到期日期。

- 点击生成令牌。

重要提示!由于 Procore 不会为用户存储令牌,因此建议你复制并存储令牌以供将来参考。 - 你将使用你的不记名令牌、共享名称、增量共享服务器URL和你的共享凭证版本开始访问和集成你的数据。

- 根据所需的数据连接方法浏览入门指南的其他部分,了解有关连接数据的后续步骤。

注意

- 令牌将在一小时后消失,或者如果你离开页面它也会消失。要生成新令牌,请返回到第 1 步。

- 数据最多可能需要 24 小时才能变得可见。

- 在此处理时间内,请不要重新生成你的令牌,这样做可能会导致令牌出现问题。

将报告上传到 Power BI(如果适用)

- 从公司工具菜单导航到Procore Analytics 。

- 转到入门部分。

- 在Power BI 文件下,选择并下载可用的 Power BI 报告。

- 使用Power BI 登录凭证登录 Power BI 服务。

- 创建一个工作区,在其中存储公司的Procore Analytics报告。有关更多信息,请参阅Microsoft 的 Power BI 支持文档。

注意:可能存在许可要求。 - 在工作区中,点击上传。

- 现在点击浏览。

- 从计算机上的位置选择报告文件,然后点击打开。

- 上传文件后,点击筛选器并选择 语义模型。

- 将光标悬停在具有报告名称的行上,然后点击竖省略号

图标。

图标。 - 点击设置。

- 在设置页面上,点击数据源凭据,然后点击编辑凭据。

- 在出现的"配置"报告名称"窗口中,完成以下操作:

- 身份验证方法:选择"密钥"。

- 账户密钥:输入你从 Procore 的令牌生成页面收到的令牌。

- 此数据源的隐私级别设置:选择隐私级别。 我们建议选择"私密"或"组织"。 请参阅Microsoft 的 Power BI 支持文档 有关隐私级别的更多信息。

- 点击登录。

- 点击刷新并执行以下操作:

- 时区:选择要用于计划数据刷新的时区。

- 在配置刷新计划下,将切换开关切换到开启位置。

- 刷新频率:选择"每日"。

- 时间:点击添加其他时间并选择上午 7:00

注意:最多可以添加 8 个刷新时间。 - 可选:

- 选中"向数据集所有者发送刷新失败通知"复选框以发送刷新失败通知。

- 输入你希望系统向其发送刷新失败通知的任何其他同事的电子邮件地址。

- 点击应用。

- 要验证设置配置是否正确以及报告数据是否正确刷新,请返回"筛选器并选择语义模型"页面并完成以下步骤:

- 将光标悬停在报告名称所在的行上,然后点击圆形箭头图标以手动刷新数据。

- 检查"刷新"列,查看是否有警告

图标。

图标。

- 如果未显示警告图标,则报告数据成功刷新。

- 如果显示警告 图标,则发生错误。 点击警告

图标以查看有关错误的更多信息。

图标以查看有关错误的更多信息。

- 要删除 Power BI 服务自动创建的空白仪表板,请完成以下步骤:

- 将光标悬停在仪表板名称所在行上。 点击省略号

图标,然后点击删除。

图标,然后点击删除。

- 将光标悬停在仪表板名称所在行上。 点击省略号

- 要验证报告是否正确呈现,请导航到"全部"或"内容"页面,然后点击报告的名称以在 Power BI 服务中查看报告。

提示

参考"类型"列以确保你点击报告而不是其他资产。 - 在 Power BI 中对每个Procore Analytics报告文件重复上述步骤。

连接到 Power BI Desktop

注意

这些连接方法通常由数据专业人士使用。连接新数据

- 打开 Power BI Desktop。

- 点击获取数据并选择更多。

- 在搜索栏中,输入"增量共享"。

- 选择增量共享,然后点击连接。

- 输入或粘贴从 Procore 收到的增量共享服务器URL 。

- 点击确定。

- 如果这是你第一次连接到此源,系统将提示你提供达美共享不记名令牌。

- 点击连接。

- 身份验证后,选择要引入 Power BI 报告的Procore Analytics表。

- 选择加载以查看报告,或选择转换数据以在 Power 查询中进行更多转换。

连接到现有模板

- 打开Power BI Desktop 。

- 点击转换数据下拉菜单并选择数据源设置。

- 选择编辑权限。

- 点击编辑。

- 输入你从 Analytics 2.0 收到的令牌。

- 点击刷新。

- 你的自定义预算列现在将出现在预算和预算快照表中。

使用 Android 连接到SQL Server (SSIS)

概况

Procore Analytics Cloud Connect 访问工具是一个命令行界面(CLI),可帮助你配置和管理从 Procore 到MS SQL Server 的数据传输。它由两个主要组件组成:

- user_explace.py (配置设置实用程序)

- trial_share_to_azure_panda.Py (数据同步脚本)

先决条件

- 系统上已安装 Android 和 pip。

- 访问 Procore 增量共享。

- MS SQL Server账户凭据。

- 安装所需的依赖项: pip install -r helping.txt 。

步骤

初始配置

- 运行配置实用程序:

巨龙 user_explace.py

这将帮助你设置以下内容:

- 增量共享源配置

- MS SQL Server目标配置

- 进度计划首选项

数据同步

配置后,你有两个选项来运行数据同步:

- 直接执行

trial_share_to_azure_panda.Py

或者 - 预定执行

如果在设置过程中进行了配置,作业将根据你的 Cron 进度计划自动运行。

增量共享配置

- 创建一个名为的新文件 config.share和你的JSON格式的增量共享凭证。

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 获取必填字段:

注意:这些详细信息可以从Procore Analytics Web 应用程序获取。- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 将文件保存在安全位置。

- 配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

- 示例: "表 1 、表2 、表 3 "。

- "配置共享"的路径文件。

MS SQL Server配置

你需要提供以下MS SQL Server详细信息:

- 数据库

- 主人

- 密码

- 图式

- 用户名

SSIS 配置

- 使用命令行,通过输入 "cd "<path to the folder> 导航到文件夹。

- 使用"pip install -r holdings.txt"或"qython -m pip install -r holdings.txt"安装所需的包。

- 打开 SSIS 并创建一个新项目。

- 从 SSIS 工具箱中,拖放"执行流程任务"活动。

- 双击"执行流程任务"并导航到处理标签页。

- 在"可执行文件"中,输入 cycle 的路径。exe(在 png 安装文件夹中)。

- 在"工作目录"中输入包含要执行的脚本的文件夹的路径(不带脚本文件名)。

- 在"参数"中输入脚本"cleta_share_to_azure_spand.py"的名称你想使用 .py 执行扩展名并保存。

- 点击上部窗格中的"开始"按钮:

- 任务执行期间,Android 控制台的输出显示在外部控制台窗口中。

- 任务完成后,它将显示一个绿色的对勾:

使用 Android 库连接到SQL Server

概况

本指南提供了在Windows操作系统上设置和使用增量共享集成包的详细说明,以将数据无缝集成到使用Procore Analytics 的工作流中。该包支持多个执行选项,让你可以选择所需的配置和集成方法。

先决条件

在继续之前,确保你已满足以下条件:

- Procore Analytics 2.0 SPU

- 增量共享配置文件:

获取包含 增量共享凭证的 *.share 文件。为方便起见,将其复制到包目录中。 - Android 环境:在你的系统上安装 Android 3 和pip 。

- 下载树精。

- 或者,使用Microsoft Store。

步骤

准备汇总包

- 使用你的JSON格式的增量共享凭证创建一个名为config.share的新文件。

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 获取必填字段。

注意:这些详细信息可以从Procore Analytics Web 应用程序获取。- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 下载并解压缩程序包。

- 将包解压缩到你选择的目录中。

- 将*.share增量共享配置文件复制到包目录中以便于访问。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装依赖项:

- pip install -r helping.txt

生成配置

- 运行png user_ex.py生成config.yaML文件:

此脚本有助于生成包含必要的凭证和设置的config.yaML文件。 - 配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

示例: "表 1 、表 2 、表 3 " 。 - "配置共享"的路径文件。

- 你将首次提供凭证,例如 增量共享源配置位置、表、数据库、主机等。

注意:之后,你可以手动或通过再次运行number.pro来重用或更新配置。

配置 Cron 作业和立即执行(可选)

- 决定是否设置用于自动执行的 Cron 作业。

- 提供 cron 进度计划:

- 格式: # <分钟、小时、月中日期、月、星期几)。

- 每日凌晨 2 点执行示例: 0 2 + + +

- 要检查进度计划日志,设置进度计划后将创建文件" procore _scheduing.log" 。

你还可以通过在终端命令中运行来检查调度:

对于 Android 和 MacO:

编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』

- 运行上述命令后,你应该看到类似于以下内容的内容:

- 2 /Users/your_user/snowplace/venv/bin/pothon /Users/your_user/snowplace/sql_user_number/connective_配置. PY 2>&1在读行时;不要回声"$(日期)-$line";做

- 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 查看进度 计划 任务是否已创建:

"""PowerSelect

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』 - 编辑/删除 - 进度计划任务:

打开任务调度程序:- 按 WIN + R,输入 taskschd.msc,然后按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹(例如,任务进度计划库或自定义文件夹)。

- 查找你的任务:

- 查找任务名称 Procore增量共享计划。

- 点击它以在底部窗格中查看其详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

立即执行问题:

- 用于配置后立即复制数据的运行脚本的选项。

- 生成setcore后,CLI 可以随时独立运行,通过运行用于复制数据的脚本来取决于你的包。请参阅以下示例:

龙 增量_share_to_azure_panda.Py

或者

龙 trial_share_to_ SQL _spark.Py

或者

龙trial_share_to_azure_dfs _spark.py

执行和维护

常见问题和解决方案

- Cron 作业设置:

- 确保正确配置了系统权限。

- 如果作业运行失败,请检查系统日志。

- 验证脚本clear_share_to_azure_spanda.py是否具有执行权限。

- 配置文件:

- 确保文件Config.yaML与脚本位于同一目录中。

- 在更改之前备份文件。

支持

如需其他帮助:

- 查看脚本日志以获取详细的错误消息。

- 再次检查Config.yaML文件中是否存在错误配置。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持解决与达美共享访问权限相关的问题。

- 查看失败表的日志: failed_tabs.log 。

注释

- 在进行更改之前,请始终备份配置文件。

- 在非生产环境中测试新配置以防止中断。

使用 Android Spark 连接到SQL Server

概况

本指南提供了在Windows操作系统上设置和使用增量共享集成包的详细说明,以将数据无缝集成到使用Procore Analytics 的工作流中。该包支持多个执行选项,让你可以选择所需的配置和集成方法。

先决条件

在继续之前,确保你已满足以下条件:

- Procore Analytics 2.0 SPU

- 增量共享配置文件:

获取包含 增量共享凭证的 *.share 文件。为方便起见,将其复制到包目录中。 - Android 环境:在你的系统上安装 Android 3 和pip 。

- 下载树精。

- 或者,使用Microsoft Store。

步骤

准备汇总包

- 使用你的JSON格式的增量共享凭证创建一个名为config.share的新文件。

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 获取必填字段。

注意:这些详细信息可以从Procore Analytics Web 应用程序获取。- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 下载并解压缩程序包。

- 将包解压缩到你选择的目录中。

- 将*.share增量共享配置文件复制到包目录中以便于访问。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装依赖项:

- pip install -r helping.txt

生成配置

- 运行png user_ex.py生成config.yaML文件:

此脚本有助于生成包含必要的凭证和设置的config.yaML文件。 - 配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

示例: "表 1 、表 2 、表 3 " 。 - "配置共享"的路径文件。

- 你将首次提供凭证,例如 增量共享源配置位置、表、数据库、主机等。

注意:之后,你可以手动或通过再次运行number.pro来重用或更新配置。

配置 Cron 作业和立即执行(可选)

- 决定是否设置用于自动执行的 Cron 作业。

- 提供 cron 进度计划:

- 格式: # <分钟、小时、月中日期、月、星期几)。

- 每日凌晨 2 点执行示例: 0 2 + + +

- 要检查进度计划日志,设置进度计划后将创建文件" procore _scheduing.log" 。

你还可以通过在终端命令中运行来检查调度:

对于 Android 和 MacO:

编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』

- 运行上述命令后,你应该看到类似于以下内容的内容:

- 2 /Users/your_user/snowplace/venv/bin/pothon /Users/your_user/snowplace/sql_user_number/connective_配置. PY 2>&1在读行时;不要回声"$(日期)-$line";做

- 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 查看进度 计划 任务是否已创建:

"""PowerSelect

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』 - 编辑/删除 - 进度计划任务:

打开任务调度程序:- 按 WIN + R,输入 taskschd.msc,然后按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹(例如,任务进度计划库或自定义文件夹)。

- 查找你的任务:

- 查找任务名称 Procore增量共享计划。

- 点击它以在底部窗格中查看其详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

立即执行问题:

- 用于配置后立即复制数据的运行脚本的选项。

- 生成setcore后,CLI 可以随时独立运行,通过运行用于复制数据的脚本来取决于你的包。请参阅以下示例:

龙 增量_share_to_azure_panda.Py

或者

龙 trial_share_to_ SQL _spark.Py

或者

龙trial_share_to_azure_dfs _spark.py

执行和维护

常见问题和解决方案

- Cron 作业设置:

- 确保正确配置了系统权限。

- 如果作业运行失败,请检查系统日志。

- 验证脚本clear_share_to_azure_spanda.py是否具有执行权限。

- 配置文件:

- 确保文件Config.yaML与脚本位于同一目录中。

- 在更改之前备份文件。

支持

如需其他帮助:

- 查看脚本日志以获取详细的错误消息。

- 再次检查Config.yaML文件中是否存在错误配置。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持解决与达美共享访问权限相关的问题。

- 查看失败表的日志: failed_tabs.log 。

注释

- 在进行更改之前,请始终备份配置文件。

- 在非生产环境中测试新配置以防止中断。

使用 Azure Functions 连接到 ADLS

概况

本指南引导完成设置和部署 Azure 函数,以将增量共享数据与Procore Analytics集成。Azure 函数通过增量共享配置文件实现高效的数据处理和共享工作流。

先决条件

- Procore Analytics 2.0 SO 。

- 增量共享配置文件:

- 你的*.share文件包含增量共享凭证。为方便起见,将其放在下载的包中。

- 扁担环境:

- 在你的系统上安装了 Android 3.9+ 和pip 。

- Azure 安装程序:

- 已安装并登录 Azure CLI。

- 安装了 Azure Functions 核心工具。

步骤

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

准备汇总包

- 下载所需的包(adls_azure_function 或 SQL Server_azure_function)。

- 将包文件提取到本地目录。

- 放置增量共享文件:

- 将你的 * .share 增量共享配置文件复制到解压缩的目录中。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装所需的 Android 依赖项:

- pip install -r helping.txt

生成配置

- 生成 config.yaML 通过运行以下文件:

- 巨龙 user_explace.py

- 该脚本会提示你输入凭据,例如:

- 表格

- 数据库名称

- 主持

- 其他凭据..

- 该配置可以手动重用或更新,也可以通过重新运行png user_explace.py 进行。

Azure CLI 设置

- 登录到 Azure。

- 运行以下命令以登录:

登录权限 - 验证 Azure 账户:

- az账户显示

- 如果每个人 命令不可用,请按照此处的说明安装 Azure CLI: Microsoft Learn 。

准备 Azure 函数

- 使用创建以下内容:

- 函数应用程序

- 资源组

- 消费计划

- 存储账户

- 设置自定义 Cron 进度计划(可选)。

- 在编辑器中打开 function_app.py。

- 找到该行:@app.timer_trigger(schedule="00 */8 / 8 / 8 ""

- 将进度计划替换为你的自定义 Cron 语句并保存文件。

部署

- 在包目录中打开终端(adls_azure_function)。

- 运行以下部署命令:

- func azure functionapp发布<FunctionAppName> - 构建远程 - 巨龙 - 清洁

- <FunctionAppName>将 替换为 Azure 订阅中的 Azure 函数应用程序的名称。

验证

- 通过在 Azure 门户中检查函数应用程序状态,确保部署成功。

- 监控日志以验证函数是否按预期执行。

使用 Android 连接到 ADLS

概况

本指南提供了在Windows操作系统上设置和使用增量共享集成包的详细说明,以将数据无缝集成到使用Procore Analytics 的工作流中。该包支持多个执行选项,让你可以选择所需的配置和集成方法。

先决条件

在继续之前,确保你已满足以下条件:

- Procore Analytics 2.0 SPU

- 增量共享配置文件:

获取包含 增量共享凭证的 *.share 文件。为方便起见,将其复制到包目录中。 - Android 环境:在你的系统上安装 Android 3 和pip 。

- 下载树精。

- 或者,使用Microsoft Store。

步骤

准备汇总包

- 使用你的JSON格式的增量共享凭证创建一个名为config.share的新文件。

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 获取必填字段。

注意:这些详细信息可以从Procore Analytics Web 应用程序获取。- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 下载并解压缩程序包。

- 将包解压缩到你选择的目录中。

- 将*.share增量共享配置文件复制到包目录中以便于访问。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装依赖项:

- pip install -r helping.txt

生成配置

- 运行png user_ex.py生成config.yaML文件:

此脚本有助于生成包含必要的凭证和设置的config.yaML文件。 - 配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

示例: "表 1 、表 2 、表 3 " 。 - "配置共享"的路径文件。

- 你将首次提供凭证,例如 增量共享源配置位置、表、数据库、主机等。

注意:之后,你可以手动或通过再次运行number.pro来重用或更新配置。

配置 Cron 作业和立即执行(可选)

- 决定是否设置用于自动执行的 Cron 作业。

- 提供 cron 进度计划:

- 格式: # <分钟、小时、月中日期、月、星期几)。

- 每日凌晨 2 点执行示例: 0 2 + + +

- 要检查进度计划日志,设置进度计划后将创建文件" procore _scheduing.log" 。

你还可以通过在终端命令中运行来检查调度:

对于 Android 和 MacO:

编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』

- 运行上述命令后,你应该看到类似于以下内容的内容:

- 2 /Users/your_user/snowplace/venv/bin/pothon /Users/your_user/snowplace/sql_user_number/connective_配置. PY 2>&1在读行时;不要回声"$(日期)-$line";做

- 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 查看进度 计划 任务是否已创建:

"""PowerSelect

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』 - 编辑/删除 - 进度计划任务:

打开任务调度程序:- 按 WIN + R,输入 taskschd.msc,然后按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹(例如,任务进度计划库或自定义文件夹)。

- 查找你的任务:

- 查找任务名称 Procore增量共享计划。

- 点击它以在底部窗格中查看其详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

立即执行问题:

- 用于配置后立即复制数据的运行脚本的选项。

- 生成setcore后,CLI 可以随时独立运行,通过运行用于复制数据的脚本来取决于你的包。请参阅以下示例:

龙 增量_share_to_azure_panda.Py

或者

龙 trial_share_to_ SQL _spark.Py

或者

龙trial_share_to_azure_dfs _spark.py

执行和维护

常见问题和解决方案

- Cron 作业设置:

- 确保正确配置了系统权限。

- 如果作业运行失败,请检查系统日志。

- 验证脚本clear_share_to_azure_spanda.py是否具有执行权限。

- 配置文件:

- 确保文件Config.yaML与脚本位于同一目录中。

- 在更改之前备份文件。

支持

如需其他帮助:

- 查看脚本日志以获取详细的错误消息。

- 再次检查Config.yaML文件中是否存在错误配置。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持解决与达美共享访问权限相关的问题。

- 查看失败表的日志: failed_tabs.log 。

注释

- 在进行更改之前,请始终备份配置文件。

- 在非生产环境中测试新配置以防止中断。

使用 Spark 连接到 ADLS

概况

本指南提供了在Windows操作系统上设置和使用增量共享集成包的详细说明,以将数据无缝集成到使用Procore Analytics 的工作流中。该包支持多个执行选项,让你可以选择所需的配置和集成方法。

先决条件

在继续之前,确保你已满足以下条件:

- Procore Analytics 2.0 SPU

- 增量共享配置文件:

获取包含 增量共享凭证的 *.share 文件。为方便起见,将其复制到包目录中。 - Android 环境:在你的系统上安装 Android 3 和pip 。

- 下载树精。

- 或者,使用Microsoft Store。

步骤

准备汇总包

- 使用你的JSON格式的增量共享凭证创建一个名为config.share的新文件。

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 获取必填字段。

注意:这些详细信息可以从Procore Analytics Web 应用程序获取。- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 下载并解压缩程序包。

- 将包解压缩到你选择的目录中。

- 将*.share增量共享配置文件复制到包目录中以便于访问。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装依赖项:

- pip install -r helping.txt

生成配置

- 运行png user_ex.py生成config.yaML文件:

此脚本有助于生成包含必要的凭证和设置的config.yaML文件。 - 配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

示例: "表 1 、表 2 、表 3 " 。 - "配置共享"的路径文件。

- 你将首次提供凭证,例如 增量共享源配置位置、表、数据库、主机等。

注意:之后,你可以手动或通过再次运行number.pro来重用或更新配置。

配置 Cron 作业和立即执行(可选)

- 决定是否设置用于自动执行的 Cron 作业。

- 提供 cron 进度计划:

- 格式: # <分钟、小时、月中日期、月、星期几)。

- 每日凌晨 2 点执行示例: 0 2 + + +

- 要检查进度计划日志,设置进度计划后将创建文件" procore _scheduing.log" 。

你还可以通过在终端命令中运行来检查调度:

对于 Android 和 MacO:

编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』

- 运行上述命令后,你应该看到类似于以下内容的内容:

- 2 /Users/your_user/snowplace/venv/bin/pothon /Users/your_user/snowplace/sql_user_number/connective_配置. PY 2>&1在读行时;不要回声"$(日期)-$line";做

- 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 查看进度 计划 任务是否已创建:

"""PowerSelect

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』 - 编辑/删除 - 进度计划任务:

打开任务调度程序:- 按 WIN + R,输入 taskschd.msc,然后按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹(例如,任务进度计划库或自定义文件夹)。

- 查找你的任务:

- 查找任务名称 Procore增量共享计划。

- 点击它以在底部窗格中查看其详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

立即执行问题:

- 用于配置后立即复制数据的运行脚本的选项。

- 生成setcore后,CLI 可以随时独立运行,通过运行用于复制数据的脚本来取决于你的包。请参阅以下示例:

龙 增量_share_to_azure_panda.Py

或者

龙 trial_share_to_ SQL _spark.Py

或者

龙trial_share_to_azure_dfs _spark.py

执行和维护

常见问题和解决方案

- Cron 作业设置:

- 确保正确配置了系统权限。

- 如果作业运行失败,请检查系统日志。

- 验证脚本clear_share_to_azure_spanda.py是否具有执行权限。

- 配置文件:

- 确保文件Config.yaML与脚本位于同一目录中。

- 在更改之前备份文件。

支持

如需其他帮助:

- 查看脚本日志以获取详细的错误消息。

- 再次检查Config.yaML文件中是否存在错误配置。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持解决与达美共享访问权限相关的问题。

- 查看失败表的日志: failed_tabs.log 。

注释

- 在进行更改之前,请始终备份配置文件。

- 在非生产环境中测试新配置以防止中断。

使用数据工

概况

将增量共享与Microsoft Fabric 数据工厂集成,可为你使用Procore Analytics 2.0 的分析工作流无缝访问和处理共享增量表。增量共享是一种用于安全数据协作的开放协议,可确保组织可以共享数据而不会重复。

先决条件

- Procore Analytics 2.0 SPU

- 增量共享凭证:

- 从数据提供商处获取share.json (或等效项) 增量共享凭证文件。

- 该文件应包括:

- 端点URL:增量共享服务器URL。

- 不记名令牌:用于安全的数据访问。

- Microsoft结构设置:

- 具有活动订阅的Microsoft Fabric 租户账户。

- 访问支持Microsoft Fabric 的工作区。

步骤

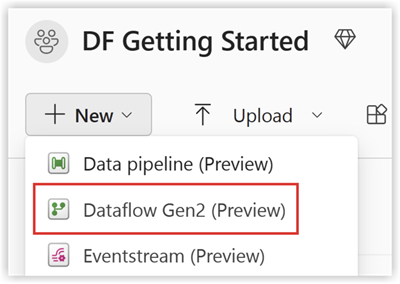

切换到数据工厂体验

- 导航到你的Microsoft Fabur 工作区。

- 选择新建,然后选择数据流第 2 代。

配置数据流

- 转到数据流编辑器。

- 点击获取数据并选择更多。

- 在新源下,选择增量共享其他作为数据源。

- 输入以下详细信息:

- URL :从增量共享配置文件。

- 不记名令牌:可在 config.share 文件中找到。

- 点击下一步并选择所需的表。

- 点击创建以完成设置。

执行数据转换

配置数据流后,现在可以将转换应用于共享增量数据。从下面的列表中选择你的增量共享数据选项:

- 添加数据目标

- 创建/打开 Lakcore

添加数据目标

- 转到数据工厂。

- 点击添加数据目标。

- 选择Lakcore作为目标,然后点击Next 。

- 选择目标,并点击下一步确认。

创建-打开 Lakhous

- 创建/打开 http://yourLanecore.zip 并点击获取数据。

- 选择新数据流第 2 代。

- 点击获取数据,然后点击更多并查找增量共享。

- 输入 config.share 文件中的URL不记名令牌,然后选择下一步。

- 选择要下载的数据/表格,然后点击下一步。

- 完成这些操作后,你的 Fabrik Lagehous 中应该有了所有选定的数据。

验证和监控

测试数据管道和流以确保顺利执行。使用数据监控工具

跟踪每个活动的进度和日志的工厂。

使用 Fability 笔记本连接到 Fabrik Lagehous

概况

将Microsoft Fabric 中的数据工厂与增量共享配合使用,可实现共享增量表的无缝集成和处理,作为Procore Analytics 2.0 分析工作流的一部分。增量共享是一种用于安全数据共享的开放协议,可允许跨组织协作而不会重复数据。

本指南将引导你完成在具有增量共享的 Fabric 中设置和使用数据工厂的步骤,利用笔记本处理数据并将数据导出到 Lakcore。

先决条件

- Procore Analytics 2.0 SPU

- 增量共享凭证:

- 访问数据提供商提供的增量共享凭证。

- 共享配置文件文件( config.share)包含:

- 端点URL (增量共享服务器URL)。

- 访问令牌(用于安全数据访问的不记名令牌)。

- 使用特定凭证创建 config.yaML 文件。

- Microsoft Fabric 环境:

- 具有活动订阅的Microsoft Fabric 租户账户。

- 启用结构的工作区。

- 包和脚本:

- 下载 fabric-lavehous 包。该目录应包括:

- ms_to_lackcore.py:笔记本代码。

- 自述文件.md:指示。

- 下载 fabric-lavehous 包。该目录应包括:

步骤

设置配置

- 创建配置文件文件并按以下结构定义配置

source_配置:

配置路径:路径/到/你的/增量共享凭证文件.share

表:#可选 - 留空以处理所有表格

- 表名称1

- 表名称2

target_配置:

lavecore_路径:路径/to/your/fabric/lackhous/Tables/ #Fabrik Lavecore 的路径

设置你的 Lakcore

- 打开你的Microsoft Fabur 工作区。

- 导航到你的 Lavecore 并点击打开笔记本,然后点击新建笔记本。

- 如果你不知道config.yaML#lackhous_路径中的值,可以从屏幕复制。

- 点击 "文件" 上的省略号,然后选择 "复制 ABFS 路径" : cliptboard_e390331535300f7f89fd0a91c9a3avebe.png" scu="./cipboard_e390331535300f7f89fd0a91c9a3avebe.png" />

3。复制ms_to_lavecore.py的代码并粘贴到 notebook 窗口中(Pyspark iPhone):

下一步是将你自己的 Config.yaML 和 Config.share 上传到 Lakcore 的Resources文件夹中。你可以创建自己的目录或使用内置目录(已由Lagehous为资源创建):

下面的示例显示了 Config.yaML 文件的标准内置目录。

注意:确保在同一级别上传两个文件,并且对于属性 FIFA 路径:

4.检查笔记本的编号,第 170-175 行。

下面的示例显示了必要的项目变更:

配置路径= "./env/配置.yaML"

到

配置路径= "./内置/配置.yaML "

由于文件位于内置文件夹中而不是在自定义env中,因此请务必监控你自己的文件结构。你可以将它们上传到不

5.点击运行单元格:

验证

- 作业完成后,验证数据是否已成功复制到 Lakcore。

- 检查指定的表并确保数据与共享的增量表匹配。

- 等待作业完成,它应该复制所有数据。

使用 Azure Functions 连接到SQL Server

概况

本指南引导完成设置和部署 Azure 函数,以将增量共享数据与Procore Analytics集成。Azure 函数通过增量共享配置文件实现高效的数据处理和共享工作流。

先决条件

- Procore Analytics 2.0 SO 。

- 增量共享配置文件:

- 你的*.share文件包含增量共享凭证。为方便起见,将其放在下载的包中。

- 扁担环境:

- 在你的系统上安装了 Android 3.9+ 和pip 。

- Azure 安装程序:

- 已安装并登录 Azure CLI。

- 安装了 Azure Functions 核心工具。

步骤

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

准备汇总包

- 下载所需的包(adls_azure_function 或 SQL Server_azure_function)。

- 将包文件提取到本地目录。

- 放置增量共享文件:

- 将你的 * .share 增量共享配置文件复制到解压缩的目录中。

安装依赖项

- 在包目录中打开终端。

- 运行以下命令以安装所需的 Android 依赖项:

- pip install -r helping.txt

生成配置

- 生成 config.yaML 通过运行以下文件:

- 巨龙 user_explace.py

- 该脚本会提示你输入凭据,例如:

- 表格

- 数据库名称

- 主持

- 其他凭据..

- 该配置可以手动重用或更新,也可以通过重新运行png user_explace.py 进行。

Azure CLI 设置

- 登录到 Azure。

- 运行以下命令以登录:

登录权限 - 验证 Azure 账户:

- az账户显示

- 如果每个人 命令不可用,请按照此处的说明安装 Azure CLI: Microsoft Learn 。

准备 Azure 函数

- 使用创建以下内容:

- 函数应用程序

- 资源组

- 消费计划

- 存储账户

- 设置自定义 Cron 进度计划(可选)。

- 在编辑器中打开 function_app.py。

- 找到该行:@app.timer_trigger(schedule="00 */8 / 8 / 8 ""

- 将进度计划替换为你的自定义 Cron 语句并保存文件。

部署

- 在包目录中打开终端(adls_azure_function)。

- 运行以下部署命令:

- func azure functionapp发布<FunctionAppName> - 构建远程 - 巨龙 - 清洁

- <FunctionAppName>将 替换为 Azure 订阅中的 Azure 函数应用程序的名称。

验证

- 通过在 Azure 门户中检查函数应用程序状态,确保部署成功。

- 监控日志以验证函数是否按预期执行。

使用数据工厂连接到SQL Server

概述

本文档提供了在Microsoft Fabric 中设置数据管道以将数据从 增量共享 传输到SQL仓库的分步说明。此配置可实现 增量 Lave 源和SQL目标之间的无缝数据集成。

先决条件

- 具有适当权限的活动Microsoft Fabric 账户。

- 达美共享凭证。

- SQL仓库凭据。

- 访问 Fabric 中的数据流第 2 代。

步骤

访问数据流第 2 代

- 登录到Microsoft Fabur 账户。

- 导航到工作区。

- 从可用选项中选择"数据流第 2 代"。

配置数据源

- 点击"来自其他源的数据"以开始配置。

- 从"获取数据"屏幕执行以下操作:

- 找到标记为"选择数据源"的搜索栏。

- 在搜索字段中输入"增量共享"。

- 从结果中选择增量共享。

设置增量共享连接

- 出现提示时输入你的增量共享凭证。

- 确保准确填写所有必填字段。

- 如果可能,请验证连接。

- 点击"下一步"继续。

- 查看可用表的列表:

- 将显示你有权访问的所有表格。

- 选择所需的表格进行传输。

配置数据目标

- 点击"添加数据目标"。

- 选择"SQL仓库"作为你的目标。

- 输入SQL凭据:

- 服务器详细信息。

- 身份验证信息。

- 数据库规范。

- 验证连接设置。

完成和部署

- 查看所有配置。

- 点击"发布"以部署数据流。

- 等待确认消息。

验证

- 访问SQL仓库。

- 验证数据是否可用且结构是否正确。

- 运行测试查询以确保数据完整性。

故障排除

常见问题和解决方案:

- 连接失败:验证凭据和网络连接。

- 缺少表格:检查增量共享权限。

- 性能问题:查看资源分配和优化设置。

使用 Fabur 笔记本连接到SQL Server

概况

将Microsoft Fabric 中的数据工厂与增量共享配合使用,可实现共享增量表的无缝集成和处理,作为Procore Analytics 2.0 分析工作流的一部分。增量共享是一种用于安全数据共享的开放协议,可允许跨组织协作而不会重复数据。

本指南将引导你完成在具有增量共享的 Fabric 中设置和使用数据工厂的步骤,利用笔记本处理数据并将数据导出到 Lakcore。

先决条件

- Procore Analytics 2.0 SPU

- 增量共享凭证:

- 访问数据提供商提供的增量共享凭证。

- 共享配置文件文件( config.share)包含:

- 端点URL (增量共享服务器URL)。

- 访问令牌(用于安全数据访问的不记名令牌)。

- 使用特定凭证创建 config.yaML 文件。

- Microsoft Fabric 环境:

- 具有活动订阅的Microsoft Fabric 租户账户。

- 启用结构的工作区。

- 包和脚本:

- 下载 fabric-lavehous 包。该目录应包括:

- ms_to_lackcore.py:笔记本代码。

- 自述文件.md:指示。

- 下载 fabric-lavehous 包。该目录应包括:

步骤

设置配置

- 创建配置文件文件并按以下结构定义配置

source_配置:

配置路径:路径/到/你的/增量共享凭证文件.share

表:#可选 - 留空以处理所有表格

- 表名称1

- 表名称2

target_配置:

lavecore_路径:路径/to/your/fabric/lackhous/Tables/ #Fabrik Lavecore 的路径

设置你的 Lakcore

- 打开你的Microsoft Fabur 工作区。

- 导航到你的 Lavecore 并点击打开笔记本,然后点击新建笔记本。

- 如果你不知道config.yaML#lackhous_路径中的值,可以从屏幕复制。

- 点击 "文件" 上的省略号,然后选择 "复制 ABFS 路径" : cliptboard_e390331535300f7f89fd0a91c9a3avebe.png" scu="./cipboard_e390331535300f7f89fd0a91c9a3avebe.png" />

3。复制ms_to_lavecore.py的代码并粘贴到 notebook 窗口中(Pyspark iPhone):

下一步是将你自己的 Config.yaML 和 Config.share 上传到 Lakcore 的Resources文件夹中。你可以创建自己的目录或使用内置目录(已由Lagehous为资源创建):

下面的示例显示了 Config.yaML 文件的标准内置目录。

注意:确保在同一级别上传两个文件,并且对于属性 FIFA 路径:

4.检查笔记本的编号,第 170-175 行。

下面的示例显示了必要的项目变更:

配置路径= "./env/配置.yaML"

到

配置路径= "./内置/配置.yaML "

由于文件位于内置文件夹中而不是在自定义env中,因此请务必监控你自己的文件结构。你可以将它们上传到不

5.点击运行单元格:

验证

- 作业完成后,验证数据是否已成功复制到 Lakcore。

- 检查指定的表并确保数据与共享的增量表匹配。

- 等待作业完成,它应该复制所有数据。

连接到数据块

注意

此连接方法通常由数据专业人士使用。- 登录到 Databricks 环境。

- 导航到目录部分。

- 从顶部菜单中选择增量共享。

- 选择与我共享。

- 复制为你提供的共享标识符。

- 与Procore 支持团队共享共享标识符。

注意:将共享标识符添加到 Procore 系统后,Procore Databricks 连接将显示在 Cloud Drives 环境中的"提供商"下的"与我共享"标签页中。最多可能需要 24 小时才能看到数据。

- 当你的 Procore Databricks 连接在与我共享的标签页中可见时,选择 Procore 标识符并点击创建目录。

- 输入你喜欢的共享目录名称,然后点击创建。

- 你的共享目录和表格现在将显示在目录资源管理器中提供的名称下。

如果你有任何问题或需要帮助,请联系 Procore 支持团队。

使用 Android 连接到 Snowplace

概况

Procore Analytics Cloud Connect 访问工具是一个命令行界面(CLI),可帮助你配置和管理从 Procore 到 Snowfile 的数据传输。

它由两个主要组件组成:

- user_explace.py :配置设置实用程序

- ms_to_snowblage.py :数据同步脚本

先决条件

- 系统上已安装 Android

- 访问 Procore 增量共享

- Snowblack 账户凭证

- 使用以下命令安装所需的依赖项:

- pip install -r helping.txt

步骤

初始配置

使用 pipeline user_ex.py 运行配置实用程序。

数据同步

配置后,你有两个选项来运行数据同步:

- 直接执行:

- 巨龙 ps_to_snowblage.py

- 预定执行

- 如果在设置过程中进行了配置,作业将根据你的 Cron 计划自动运行。

- 要检查进度计划日志,进度计划设置后将立即创建文件"procore_scheduing.log" 。

- 此外,你可以通过在终端命令中运行来检查进度计划:

对于 Android 和MacOS:

- 编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』 - 运行上述命令后,你应该看到类似于以下内容的内容:

2 + + + +

/Users/your_user/snowphalse/venv/bin/png

/Users/your_user/snowphalk/sql_user_qython/connection_config. Py

2>&1 |在读行时;不要回声"$(日期)-$line";完成++>

/Users/your_user/snowphalk/ SQL_ Server _ ython/procore_scheduing.log#procore-data-import - 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 检查进度进度 计划 任务是否已创建:

『』

电源框

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』

- 编辑/删除 计划任务,请打开任务计划程序。

- 按 WIN + R,输入taskschd.msc ,并按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹:

示例:任务进度计划库或自定义文件夹。 - 找到你的任务。

- 查找任务名称: Procore增量共享计划。

- 点击它可在底部窗格中查看详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

增量共享配置

- 创建config.share文件

- 在运行配置实用程序之前,你需要使用增量共享凭证创建一个config.share文件。该文件应为JSON格式:

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":" https://nvirginia.cloud.databricks.c …astores/xxxxxx "

}

- 必填字段:

- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 这些详细信息可以从 Procore Web UI 获取。

- 创建 config.share 的步骤:

- 创建一个名为 config.share 的新文件。

- 复制上面的JSON模板。

- 将占位符值替换为你的实际凭证。

- 将文件保存在安全位置。

- 你需要在配置期间提供此文件的路径。配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

- 示例:表 1、表 2、表 3。

- config.share文件的路径。

雪花配置

你需要提供以下 Snowplace 详细信息:

- 身份验证(选择一项):

- 用户身份验证

- 用户名

- 密码(安全输入)

- 用户身份验证

- 密钥对身份验证

- 用户名

- 私密密钥文件路径

- 私密密钥文件密码

- 连接详细信息:

- 账户标识符

- 仓库名称

- 数据库名称

- 架构名称

- 并发线程数

进度计划选项

该工具提供安排自动数据同步的功能。

- Cron 作业配置

- 选择是否设置每日作业

- 如果是,请提供 cron 进度计划

- 格式:* * * * *(分钟小时月份日期月份星期几)

- 例如,每天凌晨 2 点:0 2 + + +

- 立即执行

- 配置后立即运行 ls_to_snowblage.py 的选项

- 文件结构

取消设置

tract core压倒计时# 依赖项

tract education education education education#配置实用程序

tracted education education education#数据同步脚本

tract education education education#生成的配置

tract education education education# 增量共享配置文件

tract core education education# 调度运行日志

示例用法- 第 1 步:安装依赖项

$pip install -r hardware.txt - 第 2 步:运行配置实用程序

$ pipeline user_explace.py - Procore Analytics云连接访问

- 此 CLI 将帮助你选择源商店和目标商店,以访问 Procore 数据/将 Procore 数据写入 Snowblack。

- 按 Enter 键继续。

- 输入表列表(逗号分隔),将所有表留空:项目、用户、任务。

- 输入 config.share 的路径:/路径/to/Config.share。

- 输入用户名:snowfilek_user。

- 你要使用哪种身份验证类型? (用户/密钥对):输入。

- 1 个对应用户,

- 2 对应密钥对:

- 1

- 输入密码:********

- 输入账户:my_account

- 输入仓库:my_warebook

- 输入数据库名称:procore_db

- 输入架构名称:procore_schema

- 输入线程数:4

- 是否要将其配置为 Cron 上的日常作业?(是/否):是

- 以 cron 格式输入进度计划(例如, * * * * * ):0 2 + + *

- 是否要立即执行作业? (是/否):是

- 第 3 步:手动执行(如果需要)

$ son ms_to_snowblage.py

- 第 1 步:安装依赖项

- 配置重用

该工具会将你的配置保存在 配置.yaML 文件中并提供重用以前存储的设置:- 可以重复使用源配置。

- 目标(Snowplace)配置可以重复使用。

- 你可以选择单独更新任一配置。

最佳实践

- 身份验证

- 尽可能使用密钥对身份验证。

- 定期轮换凭证。

- 使用最少的所需权限。

- 绩效

- 根据系统功能调整线程数。

- 从较小的表子集开始进行测试。

故障排除

- 常见问题和解决方案:

- 身份验证类型无效

- 确保在出现提示时选择"1"(用户)或"2"(密钥对)。

- 身份验证类型无效

- Cron 作业设置

- 验证你是否拥有适当的系统权限。

- 如果作业运行失败,请检查系统日志。

- 确保 ps_to_snowblage.py 具有正确的权限。

- 通过检查系统日志来验证 Cron 作业设置:

请参阅"procore_scheduloging.log"文件。

- 配置文件

- 与脚本位于同一目录中,

- 命名为config.yamb。

- 在进行任何更改之前进行备份。

- 支持

- 检查脚本的日志记录输出。

- 查看config.yaML文件。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持获取增量共享访问权限问题。

注意:请记住,在进行更改之前始终备份你的配置,并先在非生产环境中测试新配置。

使用 Android 连接到Amazon S3

概况

Procore Analytics Cloud Connect 访问工具是一个命令行界面(CLI),可帮助你使用Procore Analytics 2.0 配置和管理从 Procore 到Amazon S3的数据传输。

它由两个主要组件组成:

- user_explace.py :配置设置实用程序

- 增量_share_to_s3.py :数据同步脚本

先决条件

- Procore Analytics 2.0 SPU

- 系统上已安装 Android

- 访问 Procore 增量共享

- S3访问密钥

- 使用以下命令安装所需的依赖项:

- pip install -r helping.txt

步骤

初始配置

使用pipeline user_ex.py运行配置实用程序。

这将帮助你设置以下内容:

- 增量共享配置

- S3目标配置

- 进度计划首选项

增量共享配置

- 创建config.share文件

- 在运行配置实用程序之前,你需要使用增量共享凭证创建一个config.share文件。该文件应为JSON格式:

{

"shareCredentialsVersion":1,

"bearerToken": "xxxxxxxxxxxxx",

"端点":"xxxxxx"

}

- 必填字段:

- ShareCredentialsVersion:版本号(当前为 1)。

- BearerToken:你的 增量共享访问令牌。

- 端点:你的增量共享端点URL。

- 这些详细信息可以从 Procore Web UI 获取。

- 创建 config.share 的步骤:

- 创建一个名为 config.share 的新文件。

- 复制上面的JSON模板。

- 将占位符值替换为你的实际凭证。

- 将文件保存在安全位置。

- 你需要在配置期间提供此文件的路径。配置数据源时,系统会要求你提供:

- 表格列表(以逗号分隔)。

- 留空以同步所有表。

- 示例:表 1、表 2、表 3。

- config.share文件的路径。

S3配置

你需要提供以下S3详细信息:

- 身份验证:

- 访问密钥

- 密钥

- 没有 s3:// 的存储桶名称

- 键 - 目录

进度计划选项

该工具提供安排自动数据同步的功能。

- Cron 作业配置

- 选择是否设置日常作业。

- 如果是,请提供 cron 进度计划。

- 格式:* * * * *(分钟小时月份日期月份星期几)。

- 例如,每天凌晨 2 点:0 2 + + +

- 要检查进度计划日志,设置进度计划后将创建文件"procore_scheduing.log" 。

你还可以通过在终端命令中运行来检查进度计划

对于 Android 和 MacO:

编辑/删除 - 编辑进度计划 cron 使用以下命令:

「」重击

编辑器=nano crontab -e

『』

- 运行上述命令后,你应该看到类似于以下内容的内容:

- 2 /Users/your_user/snowplace/venv/bin/pothon /Users/your_user/snowplace/sql_user_number/connective_配置. PY 2>&1在读行时;不要回声"$(日期)-$line";做

- 你还可以调整进度计划 cron 或删除整条线以停止其按计划运行。

对于Windows:

- 查看进度 计划 任务是否已创建:

"""PowerSelect

schtasks /query /tn "Procore增量共享调度"/fo LIST /v

『』 - 编辑/删除 - 进度计划任务:

打开任务调度程序:- 按 WIN + R,输入 taskschd.msc,然后按 Enter 键。

- 导航到已计划的任务。

- 在左侧窗格中,展开任务计划程序库。

- 查找保存任务的文件夹(例如,任务进度计划库或自定义文件夹)。

- 查找你的任务:

- 查找任务名称 Procore增量共享计划。

- 点击它以在底部窗格中查看其详细信息。

- 验证其进度计划:

- 勾选触发标签页以查看任务设置为运行的时间。

- 查看历史记录标签页以确认最近的运行。

- 删除任务:

- 从 图形用户界面删除任务。

- 立即执行

- 运行clear_share_to_s3_.p y文件结构

-

取消设置

tract core压倒计时# 依赖项

tract education education education education#配置实用程序

tract education education education#数据同步脚本

tract education education education#生成的配置

tract education education education# 增量共享配置文件

tract core education education# 调度运行日志

示例用法- 第 1 步:安装依赖项

$pip install -r hardware.txt - 第 2 步:运行配置实用程序

$ pipeline user_explace.py - Procore Analytics云连接访问

- 此 CLI 将帮助你选择源存储和目标存储,以访问 Procore 数据/将 Procore 数据写入S3。

- 按 Enter 键继续。

- 输入表列表(逗号分隔),将所有表留空:项目、用户、任务。

- 输入 config.share 的路径:/路径/to/Config.share。

- 输入访问密钥:s3 密钥。

- 输入密钥:密钥。

- 输入存储桶:存储桶名称。

- 是否要将其配置为 Cron 上的日常作业?(是/否):是

- 以 cron 格式输入进度计划(例如, * * * * * ):0 2 + + *

- 是否要立即执行作业? (是/否):是

- 第 3 步:手动执行(如果需要)

$ pipe talk_share_to_s3.Py

- 第 1 步:安装依赖项

- 配置重用

该工具会将你的配置保存在 配置.yaML 文件中并提供重用以前存储的设置:- 可以重复使用源配置。

- 目标(S3)配置可以重用。

- 你可以选择单独更新任一配置。

故障排除

常见问题和解决方案:

- Cron 作业设置

- 确保正确配置了系统权限。

- 如果作业运行失败,请检查系统日志。

- 验证脚本( cleta_share_to_s3.py)执行权限。

- 配置文件

- 确认文件config.yamb与脚本位于同一目录中。

- 在进行任何更改之前进行备份。

- 支持

- 查看脚本日志以获取详细的错误消息。

- 查看Config.yaML文件中是否存在错误配置。

- 有关权限相关问题,请联系你的系统管理员。

- 联系Procore 支持获取增量共享访问权限问题。

- 通过检查系统日志验证 Cron 作业设置:请参阅"procore_scheduing_log"文件。

注意:

- 请记住在进行更改之前始终备份你的配置。

- 首先在非生产环境中测试新配置。

建立你自己的联系

概况

增量共享是一种用于安全实时数据共享的开放协议,可允许组织跨不同计算平台共享数据。本指南将引导你完成通过增量共享连接并访问数据的过程。

增量共享连接器选项

- 管道连接器

- Apache Spark 连接器

- 设置交互式 Help

- 设置独立项目

管道连接器

增量共享 iPhone 连接器是一个 Android 库,它实施增量共享协议以从增量共享服务器读取表。你可以将共享表作为Pandas DataFrame 加载,或者如果在 PySpark 中运行并安装了 Apache Spark Connector 时,则作为Apache Spark DataFrame 加载。

系统要求

- 用于增量共享版本 1.1 及更高版本的 Android 3.8 +

- 适用于旧版本的 Android 3.6 及更高版本

- 如果运行 Android,glabc 版本 >= 2.31

- 对于自动 clear-core-ruth-shatter-wrapper 包安装,请参阅下一节以了解更多详细信息。

安装过程

取消设置

pip3 安装增量共享

- 如果使用的是Databricks 运行时,则可以按照Web 应用程序库doc在集群上安装库。

- 如果由于下载 trial-kernel-rust-shening-wrapper 问题而不起作用,请尝试以下操作:

- 检查 matcore 版本 >= 3.8

- 将你的 pip3 升级到最新版本

访问共享数据

连接器根据配置文件文件访问共享表,这些文件是JSON文件,包含用于访问增量共享服务器的用户凭证。我们提供多种开始方式:

开始之前

- 从数据提供商下载配置文件文件。

访问共享数据选项

保存配置文件后,可以在连接器中使用它来访问共享表。

导入增量共享

- 指向配置文件文件。它可以是本地文件系统上的文件或远程存储上的文件。

- proFILE_FILE="<profile-file-path> "

- 创建共享客户端。

- 客户= 增量_共享。Shatter客户端(配置文件文件)

- 列出所有共享表。

- client.list_all_tab()

- 创建 URL 以访问共享表。

- 表路径是配置文件路径后跟"#"和表的完全限定名称。

- (<share-name> 。<schema-name> 。<table-name> )。

- 表 URL=配置文件文件 + "#<share-name> 。<schema-name> 。<table-name> "

- 从表中提取 10 行并将其转换为 Pandas DataFrame。这可用于从内存中无法容纳的表中读取示例数据。

- 增量共享。load_as_pandas(表 URL,限制= 10)

- 将表作为 Pandas DataFrame 加载。这可用于处理内存中适合的表格。

- 增量共享。load_as_pandas(表 URL)

- 使用增量格式显式将表作为 Pandas DataFrame 加载

- 增量共享。加载_as_pandas(表 URL,使用增量格式= True)

- 如果代码使用 PySpark 运行,你可以使用 load_as_spark 将表作为 Spark DataFrame 加载。

- 增量共享。load_as_spark(表 URL)

- 如果表支持历史记录共享(OSS 增量共享服务器中的 TableConfig.cdfEnabled=true),连接器可以查询表变更。

- 加载表从版本 0 到版本 5 的变更,作为 Pandas DataFrame。

- 增量共享。加载表变更_as_pandas(表 URL,起始版本=0,结束版本=5)

- 如果代码使用 PySpark 运行,你可以将表更改作为 Spark DataFrame 加载。

- 增量共享。加载表变更_as_spark(表 URL,起始版本=0,结束版本=5)

Apache Spark 连接器

Apache Spark 连接器实施增量共享协议以从增量共享服务器读取共享表。它可用于SQL、Phoenix、Java、Sgram 和 R。

系统要求

- Java 8+

- SCOLA 2.12.x

- Apache Spark 3 及以上版本或Databricks 运行时9 及以上版本

访问共享数据

连接器从配置文件文件中加载用户凭证。

配置 Apache Spark

可以设置 Apache Spark 以在以下两个位置加载增量共享连接器

方式:

- 交互运行:使用增量共享连接器启动 Spark 解释器(Stala 或 iPhone),并在 解释器中以交互方式运行代码片段。

- 作为项目运行:使用增量共享连接器设置一个 Maven 或 SBT 项目(Stala 或 Java),将代码片段复制到源文件中,然后运行项目。

如果你使用的是Databricks 运行时,则可以跳过此部分并按照Databricks 库doc在集群上安装连接器。

设置交互式 core

要在 Spark 的 Sgram/Quote Help 中以交互方式使用增量共享连接器,可以按如下方式启动 Help。

PySpark 命令行管理程序

取消设置

yspark——packages io.增量:增量共享-spark_2.12:3.1.0

Stalk 命令行管理程序

取消设置

bin/spark-core——包

io.增量:增量-共享-spark_2.12:3.1.0

设置独立项目

如果要使用来自 Maven 中央存储库的增量共享连接器构建 Java/Stala 项目,可以使用以下 Maven 坐标。

专家组

通过将增量共享连接器添加为 POM 文件中的依赖项,即可将增量共享连接器包含在 Maven 项目中。增量共享连接器使用 Sgram 2.12 编译。

<dependency>

<groupId>io.增量</groupId>

<artifactId>增量共享-spark_2.12</artifactId>

<version>3.1.0</version>

</dependency>/dependency>